文章目录

- 创建全连接层

- 全连接层(线性层)

- 使用 PyTorch 定义全连接层

- 1. 定义一个全连接层

- 2. 查看层的参数

- 3. 使用全连接层

- 示例:构建一个简单的神经网络

- 总结

- 打印FC参数

- 输出解释

- 完整代码示例

- 示例输出

- 总结

- 线性层的参数和属性

- 线性层的参数和属性

- 线性层的其他重要属性

- 示例:查看线性层的所有参数和属性

- 输出示例

- 可选参数:无偏置项

- 输出示例

- 总结

- 打印model每一层参数

- 定义一个简单的神经网络

- 打印每一层的具体参数

- 输出示例

- 总结

创建全连接层

在深度学习中,全连接层(Fully Connected Layer)或线性层(Linear Layer)是神经网络中的基本组成部分。PyTorch 提供了一个简单的接口来定义和使用这些层,即 torch.nn.Linear。

全连接层(线性层)

一个全连接层将每个输入与每个输出连接起来,通常伴随着一个权重矩阵和一个偏置项。其计算公式为:

output = input × weight T + bias \text{output} = \text{input} \times \text{weight}^T + \text{bias} output=input×weightT+bias

其中:

- input \text{input} input是输入张量。

- weight \text{weight} weight 是权重矩阵。

- bias \text{bias} bias 是偏置项(可选)。

使用 PyTorch 定义全连接层

在 PyTorch 中,全连接层由 torch.nn.Linear 类表示。

1. 定义一个全连接层

import torch

import torch.nn as nn

# 定义一个输入维度为 4,输出维度为 2 的全连接层

fc = nn.Linear(in_features=4, out_features=2)

2. 查看层的参数

你可以查看全连接层的权重和偏置参数:

print("权重矩阵:\n", fc.weight)

print("偏置项:\n", fc.bias)

3. 使用全连接层

你可以将输入数据传递给全连接层进行前向传播(forward pass):

# 创建一个输入张量,形状为 (batch_size, in_features)

input_tensor = torch.tensor([[1.0, 2.0, 3.0, 4.0], [5.0, 6.0, 7.0, 8.0]])

print("输入张量:\n", input_tensor)

# 进行前向传播

output = fc(input_tensor)

print("输出张量:\n", output)

示例:构建一个简单的神经网络

以下是一个完整的示例,展示如何使用 nn.Linear 构建一个简单的神经网络,并进行前向传播:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个简单的神经网络,包含两个全连接层

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.fc1 = nn.Linear(4, 3) # 第一个全连接层:输入 4,输出 3

self.fc2 = nn.Linear(3, 2) # 第二个全连接层:输入 3,输出 2

def forward(self, x):

x = self.fc1(x)

x = torch.relu(x) # 使用 ReLU 激活函数

x = self.fc2(x)

return x

# 实例化神经网络

model = SimpleNN()

# 打印模型架构

print(model)

# 创建一个输入张量,形状为 (batch_size, in_features)

input_tensor = torch.tensor([[1.0, 2.0, 3.0, 4.0]])

print("输入张量:\n", input_tensor)

# 进行前向传播

output = model(input_tensor)

print("输出张量:\n", output)

输出:

SimpleNN(

(fc1): Linear(in_features=4, out_features=3, bias=True)

(fc2): Linear(in_features=3, out_features=2, bias=True)

)

输入张量:

tensor([[1., 2., 3., 4.]])

输出张量:

tensor([[..., ...]], grad_fn=<AddmmBackward0>)

总结

- 全连接层(线性层)在神经网络中用于实现输入和输出之间的线性变换。

- 在 PyTorch 中,

torch.nn.Linear用于定义全连接层。 torch.nn.Linear需要指定输入特征数和输出特征数。- 使用

nn.Linear可以方便地构建和训练神经网络。

通过上述示例,你可以理解如何在 PyTorch 中定义和使用全连接层,并将其应用于神经网络中。

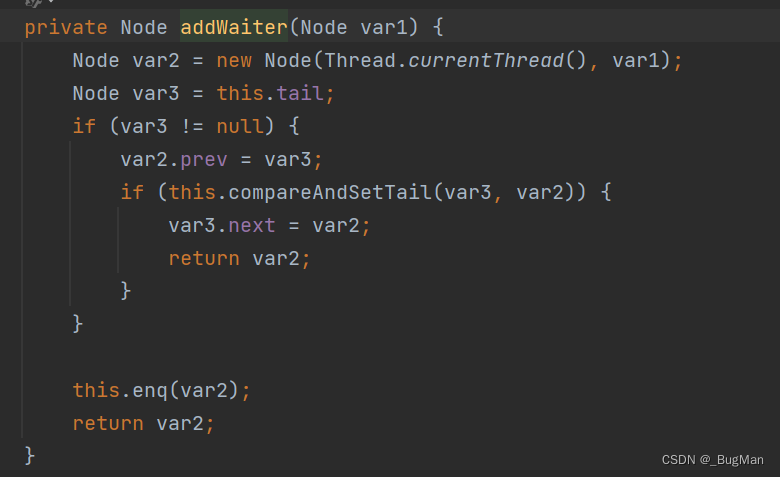

打印FC参数

要打印出 PyTorch 全连接层(线性层,nn.Linear)的参数,包括权重和偏置,可以使用以下代码示例:

import torch

import torch.nn as nn

# 定义一个输入维度为 4,输出维度为 2 的全连接层

fc = nn.Linear(in_features=4, out_features=2)

# 打印权重矩阵

print("权重矩阵 (weight):")

print(fc.weight)

# 打印偏置项

print("偏置项 (bias):")

print(fc.bias)

输出解释

fc.weight:这是一个张量,表示线性层的权重矩阵。形状为(out_features, in_features),在本例中为(2, 4)。fc.bias:这是一个张量,表示线性层的偏置项。形状为(out_features),在本例中为2。

完整代码示例

以下是一个完整的代码示例,展示如何定义一个全连接层并打印其参数:

import torch

import torch.nn as nn

# 定义一个全连接层,输入维度为 4,输出维度为 2

fc = nn.Linear(in_features=4, out_features=2)

# 打印全连接层的权重矩阵和偏置项

print("权重矩阵 (weight):")

print(fc.weight)

print("偏置项 (bias):")

print(fc.bias)

示例输出

输出可能类似于以下内容(注意:具体数值可能会有所不同,因为参数是随机初始化的):

权重矩阵 (weight):

Parameter containing:

tensor([[ 0.1476, -0.1685, 0.0569, -0.1092],

[ 0.1871, -0.2151, 0.1579, 0.0543]], requires_grad=True)

偏置项 (bias):

Parameter containing:

tensor([0.2776, 0.3281], requires_grad=True)

总结

- 使用

fc.weight和fc.bias可以分别访问线性层的权重矩阵和偏置项。 - 这些参数是

torch.nn.Parameter类型,默认情况下启用了梯度计算(requires_grad=True),以便在训练过程中进行优化。

线性层的参数和属性

在 PyTorch 中,线性层 (nn.Linear) 主要有两个参数:权重 (weight) 和偏置 (bias)。这两个参数是构成线性变换的基本要素。除此之外,线性层还具有一些属性和方法,用于配置和操作这些参数。

线性层的参数和属性

- weight:权重矩阵,是一个二维张量,形状为

(out_features, in_features)。 - bias:偏置向量,是一个一维张量,形状为

(out_features)。偏置是可选的,可以通过设置bias=False来省略。

线性层的其他重要属性

- in_features:输入特征的数量。

- out_features:输出特征的数量。

- weight:线性层的权重矩阵,类型为

torch.nn.Parameter。 - bias:线性层的偏置向量,类型为

torch.nn.Parameter,如果bias=False则为None。

示例:查看线性层的所有参数和属性

以下是一个示例,展示如何定义一个线性层并查看其参数和属性:

import torch

import torch.nn as nn

# 定义一个全连接层,输入维度为 4,输出维度为 2

fc = nn.Linear(in_features=4, out_features=2)

# 打印线性层的所有参数和属性

print("输入特征数 (in_features):", fc.in_features)

print("输出特征数 (out_features):", fc.out_features)

print("权重矩阵 (weight):")

print(fc.weight)

print("偏置项 (bias):")

print(fc.bias)

输出示例

输入特征数 (in_features): 4

输出特征数 (out_features): 2

权重矩阵 (weight):

Parameter containing:

tensor([[ 0.0841, 0.0476, 0.0294, -0.1092],

[ 0.1422, -0.0623, 0.1579, -0.0781]], requires_grad=True)

偏置项 (bias):

Parameter containing:

tensor([0.0457, 0.0912], requires_grad=True)

可选参数:无偏置项

如果不需要偏置项,可以在定义线性层时通过设置 bias=False 来省略它:

import torch

import torch.nn as nn

# 定义一个没有偏置项的全连接层

fc_no_bias = nn.Linear(in_features=4, out_features=2, bias=False)

# 打印线性层的参数和属性

print("输入特征数 (in_features):", fc_no_bias.in_features)

print("输出特征数 (out_features):", fc_no_bias.out_features)

print("权重矩阵 (weight):")

print(fc_no_bias.weight)

print("偏置项 (bias):", fc_no_bias.bias)

输出示例

输入特征数 (in_features): 4

输出特征数 (out_features): 2

权重矩阵 (weight):

Parameter containing:

tensor([[ 0.0427, -0.0897, 0.1372, -0.0811],

[-0.0635, 0.0425, -0.0312, 0.0269]], requires_grad=True)

偏置项 (bias): None

总结

nn.Linear主要包含两个参数:weight和bias。- 线性层还有一些重要的属性,如

in_features和out_features,用于描述层的配置。 - 通过设置

bias=False,可以省略偏置项。

理解这些参数和属性,有助于你更好地使用和调试线性层。

打印model每一层参数

要打印出一个 PyTorch 模型每一层的具体参数,可以使用 named_parameters() 方法。这个方法返回模型中所有参数的名称和参数张量。下面是一个示例,展示如何定义一个简单的神经网络,并打印出每一层的具体参数。

定义一个简单的神经网络

首先,我们定义一个包含多个线性层的简单神经网络:

import torch

import torch.nn as nn

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.fc1 = nn.Linear(4, 3)

self.fc2 = nn.Linear(3, 2)

self.fc3 = nn.Linear(2, 1)

def forward(self, x):

x = self.fc1(x)

x = torch.relu(x)

x = self.fc2(x)

x = torch.relu(x)

x = self.fc3(x)

return x

# 实例化神经网络

model = SimpleNN()

打印每一层的具体参数

我们使用 named_parameters() 方法来打印出模型中每一层的具体参数:

print("打印模型每一层的具体参数:")

for name, param in model.named_parameters():

print(f"层名称: {name}")

print(f"参数值:\n{param}")

print(f"参数的形状: {param.shape}")

print()

输出示例

这个代码将打印出模型每一层的名称、参数值及其形状。以下是示例输出:

打印模型每一层的具体参数:

层名称: fc1.weight

参数值:

Parameter containing:

tensor([[-0.1231, 0.0647, -0.1400, -0.0673],

[ 0.1342, 0.0033, 0.1394, -0.0781],

[-0.0621, -0.0492, -0.1162, -0.0956]], requires_grad=True)

参数的形状: torch.Size([3, 4])

层名称: fc1.bias

参数值:

Parameter containing:

tensor([-0.0956, 0.1234, -0.0443], requires_grad=True)

参数的形状: torch.Size([3])

层名称: fc2.weight

参数值:

Parameter containing:

tensor([[ 0.0570, 0.0563, -0.1074],

[ 0.0768, -0.0612, 0.1292]], requires_grad=True)

参数的形状: torch.Size([2, 3])

层名称: fc2.bias

参数值:

Parameter containing:

tensor([ 0.0428, -0.1312], requires_grad=True)

参数的形状: torch.Size([2])

层名称: fc3.weight

参数值:

Parameter containing:

tensor([[ 0.0825, 0.0076]], requires_grad=True)

参数的形状: torch.Size([1, 2])

层名称: fc3.bias

参数值:

Parameter containing:

tensor([0.0963], requires_grad=True)

参数的形状: torch.Size([1])

总结

- 使用

named_parameters()方法可以方便地访问和打印出模型中每一层的具体参数。 - 这个方法返回一个迭代器,包含参数的名称和参数张量。

这种方法对于调试和检查模型的参数非常有用。通过查看这些参数,你可以确认模型的配置是否正确,并了解每一层的具体参数值和形状。